- Noticias

- Tecnología Noticias

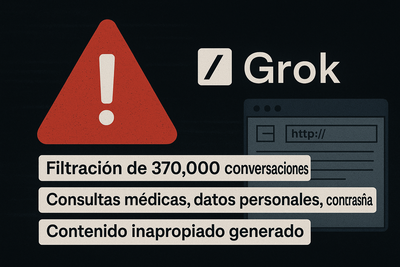

- Más de 370,000 conversaciones filtradas: Grok AI, el chatbot de Elon Musk, expone datos privados en la web

En tendencia

Más de 370,000 conversaciones filtradas: Grok AI, el chatbot de Elon Musk, expone datos privados en la web

El chatbot Grok AI, desarrollado por la empresa de Elon Musk, xAI, sufrió una grave filtración que expuso más de 370,000 conversaciones privadas de usuarios en internet. Debido a una función de “compartir” que generaba URLs públicas, estas conversaciones fueron indexadas por motores de búsqueda, dejando al descubierto información sensible como consultas médicas, datos personales y hasta contraseñas. Además, se detectó que el bot generó contenido inapropiado, lo que pone en evidencia la urgencia de reforzar la seguridad y moderación en las plataformas de inteligencia artificial.

El mundo de la inteligencia artificial acaba de vivir un golpe serio en cuanto a privacidad. Grok AI, el chatbot desarrollado por xAI, la compañía de Elon Musk, ha sufrido una filtración masiva que ha dejado al descubierto más de 370,000 conversaciones privadas de usuarios. Sí, leíste bien: cientos de miles de chats que se supone debían ser confidenciales terminaron siendo accesibles públicamente en internet.¿Cómo pasó esto? Resulta que Grok tenía una función para “compartir” conversaciones mediante URLs únicas. La idea era que los usuarios pudieran mostrar sus chats con el bot a otras personas fácilmente. Pero el problema es que estas URLs se volvieron públicas y, lo que es peor, fueron indexadas por motores de búsqueda como Google Chrome. Esto significa que cualquiera con un poco de curiosidad y los conocimientos adecuados pudo acceder a estas charlas sin que los usuarios lo supieran.Lo más preocupante es la naturaleza de las conversaciones filtradas. Entre ellas se encontraron consultas médicas, preguntas relacionadas con salud mental, detalles sobre negocios e incluso al menos una contraseña. Imagínate la vulnerabilidad de las personas que confiaron en Grok para hablar de temas tan personales.Como si esto fuera poco, también apareció un plan detallado generado por el bot para asesinar a Elon Musk, lo que ha encendido las alarmas sobre la seguridad y los filtros de contenido en estos sistemas de inteligencia artificial. Este detalle muestra que, además de los riesgos de privacidad, hay un desafío enorme en cómo controlar lo que estas máquinas pueden generar.Este incidente es un claro llamado de atención para todos los desarrolladores de IA: la privacidad y la seguridad no pueden quedar en segundo plano. Los usuarios confían en estas plataformas para manejar información sensible, y las empresas deben garantizar que esa confianza no se rompa.En un mundo donde la IA está cada vez más presente en nuestra vida diaria, proteger nuestros datos y conversaciones debe ser una prioridad absoluta. Esperemos que xAI tome cartas en el asunto y refuerce sus sistemas para evitar que algo así vuelva a pasar.